Os sacos de lixo estão sendo jogados fora de uma janela da Casa Branca, ou assim, um vídeo popular parece mostrar.

“Provavelmente gerou a IA”, disse o presidente Trump em uma entrevista coletiva na terça -feira.

Antes, um funcionário da Casa Branca sugeriu TEMPO Revista que o vídeo era real e mostrou um empreiteiro fazendo “manutenção regular”.

Aqui estamos, como outros eventos capturados ou não capturados por câmeras. As sacolas são reais ou feitas por IA? Se eles são reais, foi um mistério interessante ou apenas uma melhoria chata em casa? Não podemos saber.

Em notícias de entretenimento, os canais oficiais do ator e rapper Will Smith postaram um vídeo promovendo seu baseado em uma verdadeira turnê da história, mostrando fãs de choro e sinais escritos à mão, que os críticos criticaram por serem gerados pela IA ou aprimorados para mostrar um público maior e mais emocional do que pode ter existido. (Análise de especialistas mostrou que o vídeo provavelmente misturou conteúdo real e feito de IA.)

Smith respondeu à acusação publicando um novo vídeo do Instagram, mostrando que seu público foi feito de gatos gerados pela IA.

Obviamente, as alegações opostas sobre se uma imagem ou vídeo é gerada pela IA estão surgindo por problemas mais sérios do que a queda de sacos de lixo ou multidões de gatos.

Ele disse, ela disse

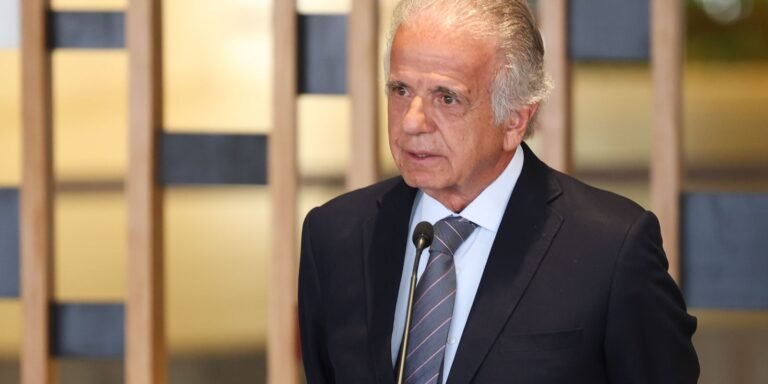

As forças armadas dos EUA nesta semana teriam matado 11 pessoas em uma greve em uma lancha de Venezuela que está carregando drogas ilegais no sul do Caribe na terça -feira. O governo postou um vídeo da greve. Mas o ministro das Comunicações da Venezuela, Freddy ñáñez, disse que o vídeo parece ser gerado pela IA.

Os políticos de Taiwan e os militares enfrentaram o uso repetido de imagens falsas geradas pela IA em campanhas de desinformação. Quando pegos em situações de compromisso em vídeo ou áudio, figuras públicas direcionadas alegaram que as gravações eram “DeepFakes” para criar dúvidas, mesmo quando verificadores de fatos e especialistas em tecnologia não encontraram prova de manipulação.

Na Índia, México, Nigéria e Brasil, os políticos acusados costumam dizer que a prova contra eles é feita pela IA. Eles não são outliers. Eles estão logo à frente da curva retórica política.

Ascensão do ‘dividendo do mentiroso’

Em 2019, quando o Audio e o vídeo Deepfake se tornaram um problema sério, os especialistas jurídicos Bobby Chesney e Danielle Citron criaram o termo “dividendo de mentiroso” para descrever a vantagem que uma figura pública desonesta recebe, chamando evidências reais de “falsidade” em uma época em que o conteúdo gerado pela IA faz as pessoas questionarem o que vêem e ouvem.

As reivindicações falsas de FeedFakes podem ser tão prejudiciais quanto os reais de DeepFakes durante as eleições. Argumentos sobre o que são ferramentas reais e não confiáveis de detecção, e a desconfiança geral permitem que os políticos desonestos chorem com Wolf por “notícias falsas” ou de DeepFakes para evitar a culpa.

Um American Political Science Review Artigo de Kaylyn Jackson Schiff, Daniel S. Schiff e Natália S. Bueno é baseado em cinco experimentos planejados, com mais de 15.000 adultos dos EUA de 2020 a 2022. Eles descobriram que, em escândalos, envolvendo políticos de ambos os principais partidos, falsas reivindicações de desinício da informação aumentavam mais do que permanecerem acentuados ou se desculpam.

Por que a nano banana tem apelo

A imagem flash Gemini 2.5 do Google, também chamada por seu nome de código interno, “Nano Banana”, é um novo modelo de geração de imagens e edição que pode criar imagens fotorrealistas.

Ele pode modificar as fotos existentes usando prompts simples. Por exemplo, você pode fazer upload de uma foto de uma pessoa acariciando um filhote e com uma frase simples de língua natural, transformá-la em uma imagem crível de uma pessoa cortando um pneu de carro.

A consistência do personagem – manter o mesmo rosto, roupas ou detalhes do objeto estável em cenas – faz com que as fotos falsas pareçam uma série de fotos de verdade. O modelo aproveita o “conhecimento mundial” mais amplo de Gemini para seguir instruções complexas e fazer edições que correspondam aos contextos do mundo real, como iluminação crível ou posicionamento de objetos.

O Nano Banana está disponível para desenvolvedores em visualização através da API Gemini, Google AI Studio e Vertex AI, ao preço de US $ 30 por 1 milhão de tokens de saída e US $ 0,039 por imagem com base em 1.290 tokens de saída. Como a Nano Banana está na API Gemini, outras empresas provavelmente a integrarão. Sites e ferramentas confirmados são OpenRouter, Fal.ai, Adobe Firefly e Adobe Express, Poe (Quora), Freepik, Figma e Pollo AI, com WPP Open e Leonardo.ai.

A capacidade de fazer falsificações estará em toda parte, juntamente com a crescente consciência de que a informação visual pode ser falsa de maneira fácil e convincente. Essa consciência faz alegações falsas de que algo é feito mais crível.

A boa notícia é que a imagem flash GEMINI 2.5 carimba todas as imagens que faz ou edita com uma marca d’água síntid oculta para identificação de IA após alterações comuns, como redimensionamento, rotação, compressão ou cópias de captura de tela. O Google diz que esse sistema de identificação abrange todas as saídas e navios com o novo modelo na API Gemini, Google AI Studio e Vertex AI.

O sintid para imagens altera os pixels sem serem vistos, mas um detector emparelhado pode reconhecê -lo posteriormente, usando uma rede neural para incorporar o padrão e outro para identificá -lo.

O detector relata níveis como “presente”, “suspeito” ou “não detectado”, o que é mais útil do que um frágil sim/não que falha após pequenas mudanças.

O OpenAI adota uma abordagem diferente para a criação de imagem Dall-E 3 e ChatGPT, conectando os metadados C2PA “Content Credenciais” que registram a ferramenta usada e um manifesto criptograficamente assinado, verificável com as credenciais de conteúdo que verificam o site. O OpenAI começou a adicionar essas credenciais em fevereiro de 2024 e admite que pode ser removido por plataformas sociais ou capturas de tela; portanto, os metadados ausentes não provam que uma imagem é feita por uma pessoa.

O serviço Azure OpenAI da Microsoft adiciona credenciais de conteúdo C2PA, assinadas para rastrear o Azure Openai, com campos como “Imagem gerada pela IA”, o agente de software e o registro de data e hora. Essas credenciais permanecem em downloads, mas podem ser removidas.

META RAECELES imagens realistas fabricadas com suas ferramentas e usa metadados IPTC e marcas d’água invisíveis, e seus pesquisadores publicaram “estável assinatura”, uma marca d’água integrada ao modelo para geradores de código aberto.

A iniciativa de autenticidade de conteúdo da Adobe e o padrão C2PA desejam fazer com que as “credenciais de conteúdo” verificadas funcionem em diferentes aplicativos e sites, para que as pessoas possam ver de onde vêm fotos e vídeos e como foram editados. A Tiktok começou a adicionar credenciais de conteúdo e pode rotular automaticamente a mídia de IA de parceiros que já enviam metadados C2PA, com verificação através das ferramentas públicas do padrão.

O Synthid faz mais sentido para mim. Mas todos esses métodos de verificação podem ser derrotados por qualquer pessoa que tenta passar fotos falsas ou vídeos como reais. Isso significa que quando alguém diz que as evidências baseadas em imagem são falsas, ninguém pode provar que eles estão errados.

A fotografia foi usada pela primeira vez como evidência do tribunal em 1859, começou a influenciar a opinião pública em 1862 com fotos da Guerra Civil e se tornou uma fonte de prova confiável nos jornais em 1880, quando a impressão de meio -medone permitiu que os editores imprimissem fotos reais em impressões de jornais.

Isso significa que o conteúdo visual feito por câmera serviu como provas confiáveis e convincentes por 166 anos.

Adeus, evidências fotográficas e em vídeo confiáveis com as quais todos poderíamos concordar. Dificilmente os conhecíamos.

Fonte: Computer World